加强人工智能大模型安全防护:刻不容缓

加强人工智能大模型安全防护:刻不容缓的行动

随着人工智能技术的飞速发展,大模型的应用越来越广泛。从语音助手到智能客服,再到自动驾驶汽车,大模型正在改变我们的生活方式。然而,随着其应用的普及,大模型的安全问题也日益凸显。本文将探讨当前人工智能大模型面临的安全挑战,并提出加强安全防护的几点建议。

一、引言

近年来,人工智能大模型在语音识别、自然语言处理、图像识别等领域取得了显著成果。这些大模型通过深度学习技术,能够处理大量的数据,并生成高质量的输出结果。然而,随着其应用的深入,大模型的安全问题也逐渐浮出水面。

二、人工智能大模型面临的安全挑战

-

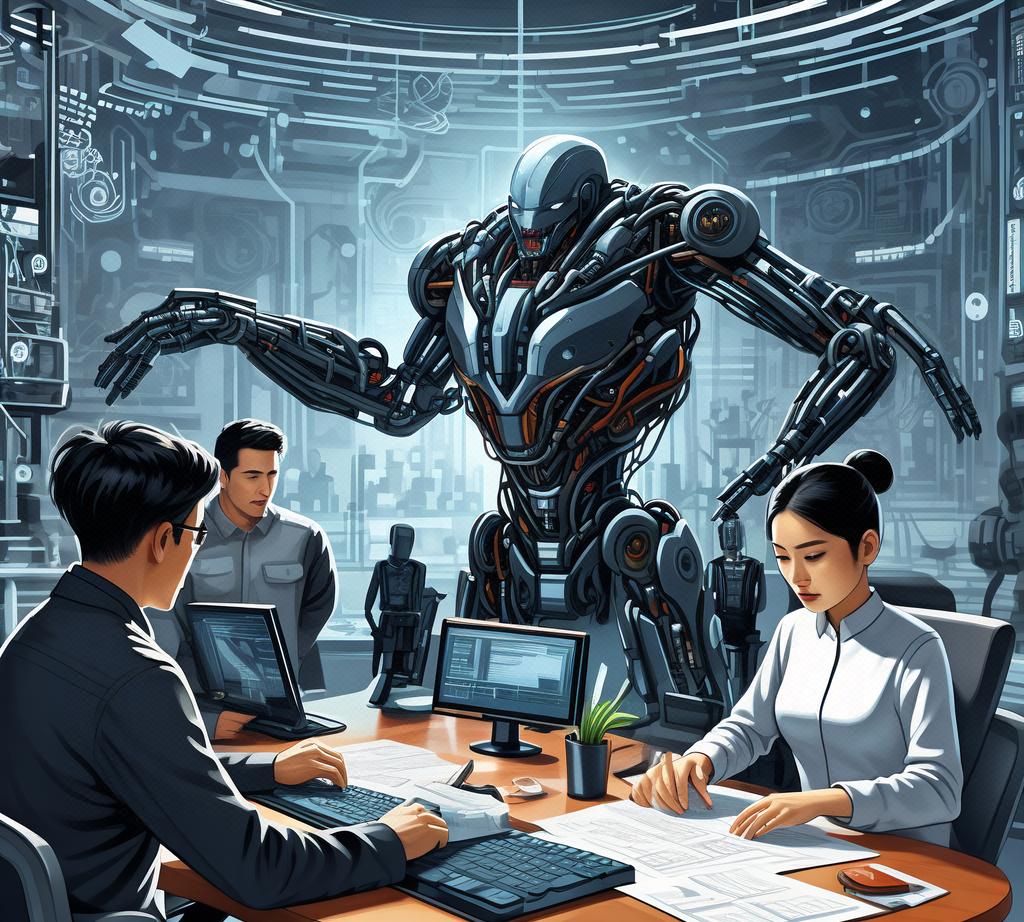

数据泄露风险:人工智能大模型需要大量的数据进行训练和优化。然而,数据的收集、存储和处理过程中,存在数据泄露的风险。攻击者可以通过窃取数据,获取模型的敏感信息,进而攻击模型。

-

注入式攻击:攻击者通过向模型中注入恶意数据,干扰模型的训练和推理过程。这种攻击可能导致模型的性能下降,甚至导致模型失效。

-

模型窃取:攻击者通过监听、拦截等方式,获取模型的参数和结构信息,然后复制模型,从而绕过正版模型的授权机制。

三、具体案例

以某知名语音助手为例。该语音助手采用了大规模的语言模型,能够为用户提供智能的语音交互体验。然而,攻击者通过向模型中注入恶意语音数据,导致语音助手误识别指令,甚至执行恶意操作。此外,攻击者还可能通过窃取模型的参数和结构信息,复制出相似的模型,从而绕过正版模型的授权机制。

四、加强人工智能大模型安全防护的几点建议

-

加强数据保护:在数据的收集、存储和处理过程中,应采用加密技术、访问控制等措施,防止数据泄露。

-

强化模型安全性验证:在模型的训练和推理过程中,应加入安全验证机制,防止注入式攻击。例如,可以采用数据清洗、异常检测等技术,识别并过滤恶意数据。

-

加强模型知识产权保护:采用加密技术、数字签名等手段,保护模型的参数和结构信息。同时,建立严格的授权机制,防止模型被非法复制和使用。

-

提升安全意识:企业和开发者应加强对人工智能安全的认识,了解大模型面临的安全风险和挑战。同时,加强安全培训,提高员工和用户的安全意识。

五、结论

人工智能大模型的安全问题已成为一个亟待解决的问题。随着大模型在各个领域的应用越来越广泛,其安全问题也变得越来越重要。企业和开发者需要重视大模型的安全问题,采取有效措施,提高大模型的安全性。

加强人工智能大模型的安全防护,不仅需要技术层面的改进,更需要法律、政策和道德层面的支持。政府应制定相关法律法规,保护人工智能大模型的知识产权和安全性。同时,企业和开发者也应加强自律,遵守相关法律法规,共同维护人工智能大模型的安全。

此外,加强人工智能大模型的安全防护,还需要加强国际合作。随着人工智能技术的不断发展,大模型的应用已经超越了国界。因此,各国应加强合作,共同制定相关标准和规范,共同应对大模型的安全问题。

总之,加强人工智能大模型的安全防护,是当务之急。只有通过技术、法律、政策和道德等多方面的努力,才能确保人工智能大模型的安全性和可靠性,为人工智能技术的健康发展提供有力保障。